Plötzlich taucht ein Video auf: Ein Politiker sagt etwas Skandalöses, eine Influencerin verbreitet wirre Aussagen, ein Chef ruft angeblich mit einer dringenden Geldanweisung an. Alles wirkt echt – aber nichts davon stimmt. Alles sieht verblüffend echt aus – doch kannst du wirklich noch glauben, was du siehst? Willkommen in der Welt der Deepfakes. Was früher wie Science-Fiction klang, ist heute erschreckende Realität: Künstlich erzeugte Fälschungen, die täuschend echt aussehen, sind auf dem Vormarsch. In diesem Artikel erfährst du, wie Deepfakes funktionieren, welche Formen sie annehmen, welche Gefahren sie bergen und wie du dich im Alltag davor schützen kannst.

Was sind Deepfakes?

Der Begriff Deepfake ist eine Wortkombination aus „Deep“ (für Deep Learning, einer KI-Technik mit künstlichen neuronalen Netzen) und „Fake“ (Fälschung). Gemeint sind damit Foto-, Video- oder Audioaufnahmen, die mithilfe von KI so manipuliert oder synthetisch erzeugt wurden, dass sie täuschend echt erscheinen. Vereinfacht gesagt „lernt“ ein Computer anhand vieler Beispiele (etwa Bildern oder Sprachaufnahmen) die Merkmale einer Person und kann anschließend neue, gefälschte Aufnahmen generieren. So lässt sich z.B. das Gesicht einer Person nahtlos auf den Körper einer anderen übertragen oder eine Stimme künstlich nachahmen.

Das Ergebnis: Videos, in denen Menschen Dinge sagen oder tun, die sie nie gesagt oder getan haben. Anders als bei herkömmlichen Bildmontagen oder offensichtlich gestellten Fake-Videos sind Deepfakes oft erst auf den zweiten Blick als Fälschung erkennbar. Moderne KI-Modelle wie neuronale Netzwerke oder GANs (Generative Adversarial Networks) optimieren die Fakes so lange, bis das Ergebnis überzeugend wirkt. Dadurch können Personen in Videos scheinbar Dinge sagen oder tun, die sie nie gesagt oder getan haben. Ein bekanntes Beispiel ist der „Deepfake-Tom-Cruise“ auf TikTok – ein Nutzer erstellte Videos, in denen Schauspieler Tom Cruise verblüffend realistisch imitiert wurde. Dieses und andere Deepfake-Beispiele zeigen: Man kann seinen Augen und Ohren nicht mehr blind vertrauen, denn KI macht nahezu perfekte Illusionen möglich.

Gesichter, Stimmen, Bewegungen: Die Formen der KI-Fälschung

Deepfakes können unterschiedliche Formen annehmen, je nachdem welche Art von Medium manipuliert wird. Im Wesentlichen lassen sie sich in Gesichts-Fälschungen, Stimmen-Kopien und allgemeine Videomanipulationen einteilen. Zudem gibt es mittlerweile zahlreiche Deepfake-Apps und -Tools, mit denen auch Laien solche Fälschungen erstellen können. Hier ein Überblick der wichtigsten Arten:

Gesichtsfälschungen (Face-Swap & Co.)

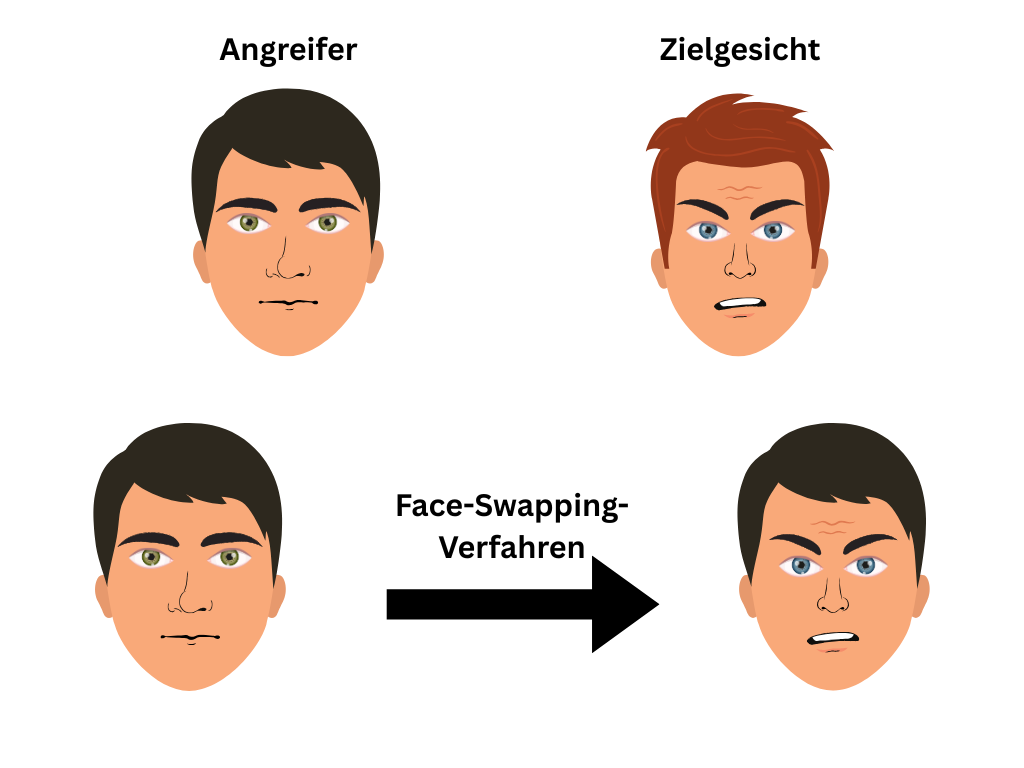

Eine weitere Variante ist Face Reenactment. Hierbei wird das Gesicht einer Person in einem Video fern-gesteuert: Mimik, Lippenbewegungen oder Kopfbewegungen werden künstlich verändert. So ließe sich z.B. ein echtes Interview-Video nehmen und die Mundbewegungen des Interviewten so manipulieren, dass er andere Worte „spricht“. Gesichtsfälschungen sind visuell am auffälligsten – sie reichen von harmlosen Spaß-Videos (etwa wenn mittels App das eigene Gesicht auf bekannte Filmszenen montiert wird) bis zu gefährlichen Täuschungsmanövern in Politik und Medien.

Schema einer KI-Gesichtsfälschung: Beim Face-Swapping wird das Gesicht der Zielperson (rechts) durch das des Angreifers (links) ersetzt. Ein neuronales Netz lernt die Merkmale und generiert am Ende das manipulierte Bild (rechts unten) – das Lächeln des Angreifers erscheint mit dem Gesicht der Zielperson.

Stimmfälschungen (synthetische KI-Stimmen)

Noch perfider sind Audio-Deepfakes. Hier klont die KI-Stimmen. Bei solchen Audio-Deepfakes analysiert eine KI zahlreiche Sprachaufnahmen einer Person, bis sie deren Stimmlage, Tonfall und Sprechtempo imitiert hat. Anschließend kann man der KI beliebigen Text eingeben – und sie spricht ihn mit der geklonten Stimme. Auf diese Weise wurden schon prominente Stimmen nachgeahmt (man denke an Deepfake-Audio von Barack Obama oder Donald Trump in Satire-Videos). Doch die Technik wird auch kriminell eingesetzt: Bereits 2019 berichtete die Süddeutsche Zeitung von einem Betrugsfall, bei dem ein Manager glaubte, den Anruf seines Chefs zu hören – in Wirklichkeit sprach eine KI-Klonstimme, die ihn zur Überweisung von 220.000 € überredete. Auch hierzulande schlagen Polizei und Verbraucherschützer Alarm, denn Betrüger nutzen KI-Stimmen z.B. für den Enkeltrick (sie geben sich telefonisch als Verwandte in Not aus).

KI-Stimmen kommen zudem in Videos zum Einsatz: Oft wird Bild und Ton kombiniert gefälscht, um eine maximale Illusion zu erzeugen. Ein Deepfake-Video kann also sowohl das Gesicht als auch die Stimme einer Person künstlich nachbilden. Dadurch wirken z.B. gestellte Botschaften von Politikern noch authentischer, weil nicht nur das Bild stimmt, sondern auch die Stimme passt. Moderne Text-to-Speech-Systeme (etwa in Navigationsgeräten oder Sprachassistenten) zeigen, wie natürlich computergenerierte Stimmen heute klingen – das gleiche Prinzip wird bei Stimm-Deepfakes missbraucht, um falsche Aussagen in den Mund echter Personen zu legen.

Videomanipulationen (Mimik & Bewegungen)

Neben dem vollständigen Gesichtertausch oder Sprachfälschungen gibt es auch teilweise Videomanipulationen. Dabei verändern sie Aufnahmen so, dass bestimmte Inhalte falsch dargestellt erscheinen. Ein bekanntes Beispiel ist das sogenannte Lip-Sync-Deepfake: Hier passt man die Lippenbewegungen einer Person nachträglich an eine neue Audiospur an. So kursierte vor einigen Jahren ein Fake-Video von US-Präsident Obama, in dem er scheinbar ungewöhnliche Dinge sagte – in Wahrheit hatte man ein altes Video genommen und Obamas Lippen per KI zu einer neuen Rede bewegt (die Stimme stammte von einem Imitator, kombiniert mit der manipulierten Mundbewegung). Ähnlich arbeitet das sogenannte Face Reenactment, das wir bereits angesprochen haben: Deepfake-Ersteller agieren dabei wie digitale Puppenspieler, indem sie die Mimik eines Gesichts im Video nach Belieben steuern. Sie können sogar ganze Bewegungsabläufe übertragen – etwa, indem sie eine Person tanzen lassen, obwohl sie diese Bewegung nie ausgeführt hat. Dafür übernehmen sie einfach die Bewegungsdaten einer anderen Person.

Solche Videomanipulationen erfordern zwar aufwändige Technik, sind aber nicht mehr Science-Fiction. Forschungsprojekte zeigten z.B. schon, wie man in Live-Videokonferenzen die Mimik in Echtzeit manipulieren kann. Für Aufsehen sorgte auch ein Deepfake-Experiment des ZDF, bei dem in einer Talkshow die Gesichter von Politikerinnen live ausgetauscht wurden, um die Gefahren zu demonstrieren. Diese Teilfälschungen sind oft noch erkennbar (z.B. wirken Gestik oder Proportionen unnatürlich), aber die Qualität wird stetig besser.

Deepfakes-App & Tools: Wie leicht du KI-Fälschungen erstellen kannst

Das Gefährliche: All diese Techniken sind nicht mehr nur Profis vorbehalten. Es gibt zahlreiche Deepfake-Apps und benutzerfreundliche Programme, mit denen man in wenigen Minuten eigene KI-Fakes basteln kann. Ein prominentes Beispiel war die App Zao aus China, die 2019 viral ging: Nutzer konnten ihr Gesicht in Filmszenen einsetzen – mit verblüffend echtem Ergebnis. Beliebt für Spielereien ist auch die App Reface, mit der man sein Gesicht auf GIFs und Videos kleben kann. Gleichzeitig kursieren Open-Source-Tools wie DeepFaceLab oder FaceSwap, die etwas technisches Know-how erfordern, aber frei verfügbar sind.

Die breite Verfügbarkeit solcher Tools führt dazu, dass zahlreiche Deepfakes im Umlauf sind – Tendenz steigend. Laut KI-Experten hat es in den letzten Jahren einen Riesenschub gegeben: Durch neue generative KI-Modelle ist es „super einfach geworden“, Deepfakes per Software zu erstellen. Eine Untersuchung zeigte sogar, dass man mit einer frei erhältlichen Premium-App ohne Vorkenntnisse in Minuten ein Gesichts-Deepfake in ein Video einfügen kann. Kurz gesagt: Vom harmlosen Gesichtsfilter bis zum komplexen Fälschungsprogramm – die Tools sind da, und sie werden immer leistungsfähiger.

Was sind die Risiken und Gefahren?

Täuschend echte Fälschungen aus KI-Hand – das klingt beängstigend, und tatsächlich bergen Deepfakes erhebliche Risiken. Im Folgenden die wichtigsten Gefahren und wieso wir wachsam sein müssen:

Politik & Wahlen: In Wahlkampfzeiten tauchen zunehmend Deepfakes auf, die Politiker:innen gezielt diskreditieren sollen. Ein Beispiel: Kurz vor der Bundestagswahl 2025 verbreitete sich ein gefälschtes Tagesschau-Video, das die Vereidigung von Alice Weidel zeigte – komplett KI-generiert. Auch international wurden Fake-Videos wie das gefälschte Selenskyj-Kapitulationsvideo bekannt. Ziel ist stets: Misstrauen säen, Debatten polarisieren, Demokratie schwächen.

Identitätsdiebstahl & Betrug: Mit gefälschten Stimmen oder Gesichtern können Kriminelle am Telefon oder in Videos Vertrauen erschleichen. Beim sogenannten CEO-Fraud etwa wurde durch eine Deepfake-Stimme ein Überweisungsauftrag über 220.000 € ergaunert. Auch Fake-Profile in sozialen Netzwerken oder manipulierte Videobotschaften im Phishing-Kontext sind denkbar – die Maschen werden raffinierter.

Erpressung mit intimen Deepfakes („Sextortion“): Kriminelle montieren Gesichter aus Social-Media-Fotos in pornografische Szenen und drohen mit der Veröffentlichung – auch wenn nie echte Nacktbilder existierten. Die seelische Belastung ist enorm: Scham, Angst und das Gefühl von Kontrollverlust machen diese Form digitaler Gewalt besonders traumatisch. Wichtig ist, solche Erpressungen ernst zu nehmen, nicht zu zahlen und Anzeige zu erstatten.

Deepfake-Pornografie und digitale Gewalt: Rund 96 % aller im Netz kursierenden Deepfakes sind pornografisch – und fast ausschließlich gegen Frauen gerichtet. Was mit Prominenten begann, betrifft inzwischen auch viele Privatpersonen. In Foren kursieren Aufrufe wie „Fake her!“, bei denen gezielt Fotos von Frauen gesammelt werden, um daraus gefälschte Nacktaufnahmen zu erstellen. Auch ohne finanzielle Forderung verursachen diese Inhalte massiven Schaden: Sie verletzen Persönlichkeitsrechte, zerstören Vertrauen und können zu Mobbing oder sozialer Ausgrenzung führen. Rechtlich fallen derartige Fälle in Deutschland unter Persönlichkeitsverletzung und ggf. „Rachepornografie“-Gesetze, doch die Rechtslage hält mit der technischen Entwicklung oft kaum Schritt. Es gibt jedoch Bestrebungen, die Strafbarkeit von Deepfake-Missbrauch zu verschärfen (z.B. plant Großbritannien, bereits die Erstellung von Deepfake-Nacktbildern unter Strafe zu stellen).

Wie erkennt man Deepfakes?

Angesichts dieser Gefahren stellt sich die Frage: Wie kann man Deepfakes erkennen? Leider gibt es keine hundertprozentig einfache Methode, da die Fälschungen immer besser werden. Dennoch gibt es einige Anzeichen, auf die du achten kannst, sowie technische Hilfsmittel, die bei der Erkennung helfen. Hier ein paar Tipps, um KI-Fälschungen zu entlarven:

Unnatürliche Gesichtsdetails: Achte auf kleine Fehler im Bild. Häufige Anomalien sind z.B. Artefakte an den Rändern des Gesichts (Übergänge, die leicht verschwimmen) oder ein etwas verzerrter Haaransatz. Auch begrenzte Mimik kann ein Hinweis sein. Frühere Deepfakes hatten oft das Problem, dass die gefälschte Person kaum blinzelte. Moderne Fakes sind besser, aber ein holzschnittartiger Gesichtsausdruck kann verdächtig sein. Ebenso passen manchmal Licht und Schatten nicht perfekt: Wenn z.B. das Gesicht anders beleuchtet ist als der Hals/Hintergrund, könnte es ein Fake sein.

Unstimmigkeiten bei Bewegungen: Schau dir auch den Hintergrund und die Ränder genau an. Springen einzelne Bildbereiche oder wirken bei Kopfbewegungen verzogen? Auch fehlende Details wie keine Reflexionen in Brillengläsern, unnatürlich glatte Haut oder verschwommene Ohrringe können verraten, dass ein Video generiert ist. Bei komplexen Bewegungen (z.B. schnelle Kopfdrehungen) kann das Bild leicht flackern oder unscharf werden, was im Originalvideo nicht so wäre.

Ton & Sprache: Falls es um Audio oder eine Stimme geht, hör genau hin. Klingt die Stimme ein bisschen metallisch oder monoton? Ein häufiges Merkmal von KI-Stimmen ist ein leicht robotischer Klang oder unnatürliche Pausen. Auch falsche Aussprache kann vorkommen – zum Beispiel wenn Namen oder Fremdwörter merkwürdig betont werden. Zudem wirken Deepfake-Audios oft zu sauber oder haben seltsame Störgeräusche. Im Falle des gefälschten Tagesschau-Videos konnte man z.B. bei genauem Hinhören feststellen, dass die Nachrichtensprecherin ein wenig mechanisch klingt – dieses leicht Unnatürliche entlarvt die KI-Stimme.

Inhalt und Kontext prüfen: Neben technischen Hinweisen sollte man immer den Inhalt hinterfragen. Wenn ein Video überraschend ist, aber keine anderen Medien darüber berichten, ist Vorsicht geboten. Ein hilfreicher Trick: Screenshot machen und per Google Bilder-Rückwärtssuche prüfen, ob der Frame schon früher irgendwo auftauchte (und vielleicht in anderem Zusammenhang verwendet wurde).

Technische Deepfake-Detektoren: Es gibt mittlerweile auch Tools, die speziell Deepfakes aufspüren sollen. Microsofts Video Authenticator oder Sensity AI helfen, Deepfakes zu erkennen. Solche Tools können hilfreich sein, jedoch ist ihre Zuverlässigkeit noch begrenzt. Die Fälscher entwickeln ihre Technik ständig weiter, oft schneller als die Gegenmaßnahmen mithalten können

Fazit: Deepfakes sind real – aber Wissen schützt dich

Deepfakes sind eine der größten Herausforderungen der digitalen Gegenwart. Sie können unterhalten – aber auch schaden. Wer die Mechanismen kennt, kann sich schützen. Wissen ist der beste Filter gegen digitale Lügen. Und Aufklärung das beste Mittel gegen Angst. Langfristig arbeiten auch Tech-Firmen und Gesetzgeber daran, bessere Schutzmechanismen zu entwickeln – von digitalen Wasserzeichen in echten Videos bis zu strengeren Gesetzen für Deepfake-Missbrauch.

Teste dein Deepfake-Radar in der Praxis

Du kennst jetzt die Theorie – doch erkennst du täuschend echte KI-Fakes auch im Alltag? Finde es in unserem interaktiven Deepfake-Bilder-Quiz heraus.

- 8 realistische Bildsets – mal suchst du das KI-Bild, mal das Original.

- Sofort-Feedback per Klick auf „Prüfen“: grün = Treffer, rot = Fehlgriff.

- Kurzanalysen verraten dir die verräterischen Details hinter jedem Motiv.

Quellen / Referenzen anzeigen

- https://de.wikipedia.org/wiki/Deepfake

- https://www.bsi.bund.de/DE/Themen/Unternehmen-und-Organisationen/Informationen-und-Empfehlungen/Kuenstliche-Intelligenz/Deepfakes/deepfakes_node.html

- https://www.bundesregierung.de/breg-de/aktuelles/was-sind-deep-fakes-2230226

- https://www.dfki.de/web/news-media/news-events/interview-was-sind-eigentlich-deepfakes

- https://www.rnd.de/digital/deepfakes-erkennen-auf-welche-hinweise-sie-bei-audio-und-videomanipulationen-achten-koennen-4GCHCB6RM3SDXJZ7WFCPDX37P4.html

- https://www.spiegel.de/netzwelt/web/meta-loescht-fake-video-das-wolodymyr-selenskyj-falsche-worte-in-den-mund-legt-a-5600045c-8057-4359-bd31-ee02c6e585d5

- https://www.bsi.bund.de/DE/Themen/Unternehmen-und-Organisationen/Informationen-und-Empfehlungen/Kuenstliche-Intelligenz/Deepfakes/deepfakes.html

- https://www.sueddeutsche.de/wirtschaft/ki-deepfake-versicherung-betrug-1.4493902

- https://www.tagesschau.de/faktenfinder/ki-fakes-tagesschau-100.html

- https://www.tagesschau.de/investigativ/deepfakes-103.html

- https://www.tagesschau.de/investigativ/deepfakes-103.html

- https://www.welivesecurity.com/de/cybercrime/was-man-ueber-deepfake-gesteuerte-sextortion-wissen-sollte/

- https://www.tagesschau.de/investigativ/deepfakes-103.html

- https://www.bpb.de/lernen/bewegtbild-und-politische-bildung/556843/strafrecht-und-regulierung-von-deepfake-pornografie/

- https://www.kaspersky.de/resource-center/threats/protect-yourself-from-deep-fake